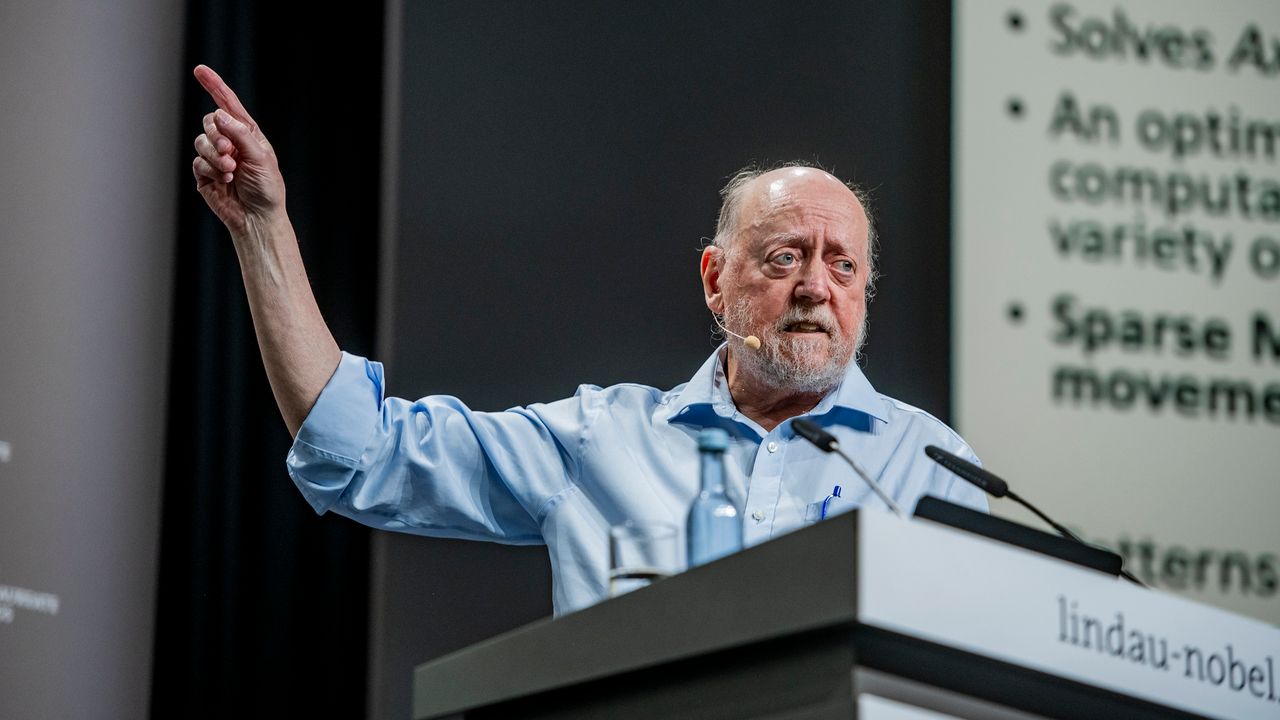

Au 74ᵉ Lindau Nobel Laureate Meeting, Jack Dongarra, informaticien de renom et lauréat du Turing Award 2021, a livré sa vision sur l’avenir du supercalcul et son mariage avec l’intelligence artificielle. Sur les rives du lac de Constance, ses propos ont souligné la transition d’un modèle centré sur le hardware vers une approche systémique, où algorithmes, données et architectures évoluent de concert pour repousser les limites de la performance.

De l’ère du matériel à celle des systèmes hybrides

Historiquement, la course au supercalcul reposait sur des processeurs toujours plus rapides et des grappes de CPU reliées par des réseaux à très basse latence. Aujourd’hui, Dongarra rappelle que c’est l’intégration harmonieuse de plusieurs unités de calcul qui fera la différence :

- Les CPU restent le cœur généraliste du système, gérant la logique séquentielle et les tâches diversifiées.

- Les GPU, initialement dédiées à la 3D, apportent une puissance de calcul parallèle massive – indispensable à l’entraînement de réseaux de neurones profonds.

- À l’avenir, des accélérateurs quantiques, neuromorphiques ou optiques pourront se greffer à cette plate-forme pour traiter des algorithmes spécifiques de façon ultra-optimisée.

L’IA : moteur de la recherche et catalyseur d’innovation

Pour Dongarra, l’intelligence artificielle ne se contente pas d’être une nouvelle application du supercalcul ; elle transforme la méthode scientifique elle-même :

- En approximant des modèles complexes, l’IA réduit drastiquement le temps de simulation et le coût en ressources.

- Elle permet d’extraire des tendances et des anomalies dans d’immenses jeux de données, ouvrant des perspectives de découverte inaccessibles auparavant.

- Dans des secteurs aussi variés que la climatologie, la biologie moléculaire ou l’astrophysique, l’IA combine calcul numérique et apprentissage pour affiner les prédictions.

Selon lui, l’impact global de l’IA sur la science pourrait surpasser celui d’Internet, en modifiant non seulement nos interactions, mais aussi la manière dont nous concevons et codons nos algorithmes.

Le quantique : promesse lointaine et défis concrets

Le calcul quantique alimente actuellement un véritable « hype cycle », mais Dongarra invite à la prudence :

- Les machines quantiques disponibles comptent encore un nombre restreint de qubits, soumis à des erreurs de décohérence et à un fort taux d’imprécision.

- Chaque calcul fournit un ensemble de résultats probabilistes et requiert de nombreuses répétitions pour dégager des statistiques fiables.

- Il faudra développer des cadres théoriques, des compilateurs et des méthodes de vérification dédiées aux environnements quantiques.

Pour lui, la véritable révolution viendra d’architectures composites où les CPU, GPU et modules quantiques cohabitent, chacun apportant ses atouts pour des tâches ciblées.

Écosystèmes géopolitiques et souveraineté technologique

Les tensions entre grandes puissances redessinent la carte du supercalcul :

- Les États-Unis restreignent l’export de GPU haut de gamme pour freiner l’avancée technologique de la Chine.

- Pékin investit massivement dans la recherche de puces locales et dans la construction de fermes de calcul comparables aux géants occidentaux.

- Le risque d’insularité se profile : la fragmentation des standards et des chaînes logistiques pourrait freiner la collaboration internationale.

Pour Dongarra, la compétition privilégie l’innovation, mais elle impose de maintenir des ponts entre les communautés scientifiques afin d’éviter un « effet silo » préjudiciable à la recherche globale.

L’avenir des développeurs à l’ère de l’IA

Face à l’émergence de systèmes génératifs capables de produire du code sur simple directive en langage naturel, Dongarra entrevoit une transformation profonde du métier :

- Les développeurs deviendront des concepteurs de problèmes, définissant les exigences et validant les solutions proposées par l’IA.

- Les tâches répétitives de syntaxe ou d’optimisation seront automatisées, réduisant le temps entre l’idée et la réalisation.

- Il restera indispensable de maîtriser l’architecture logicielle, la sécurité et l’éthique pour garantir la fiabilité du code.

En écho, la formation des nouvelles générations devra privilégier la pensée algorithmique, la modélisation de problèmes et la capacité à orchestrer des pipelines de calcul hétérogènes.

Vers une convergence des technologies de calcul

L’héritage de la conférence de Lindau restera cette vision d’un écosystème de calcul modulaire, combinant :

- Les architectures traditionnelles CPU+GPU pour les workloads classiques et l’IA haute performance.

- Des co-processeurs quantiques pour des algorithmes de cryptographie et d’optimisation spécifiques.

- Des dispositifs neuromorphiques et optiques pour des traitements de données en temps réel et des applications embarquées.

- Des moteurs analogiques pour certaines simulations physiques d’une efficacité énergétique inégalée.

La clé du succès résidera dans la capacité à intégrer ces composants au sein d’un même système, orchestré par un middleware capable d’allouer dynamiquement les tâches à la ressource la plus adaptée, tout en garantissant fiabilité, sécurité et performance durable.