Du « suprématie » à l’« avantage quantique » vérifiable

En 2019, Google affirmait avoir atteint la « suprématie quantique » grâce à son processeur Sycamore de 53 qubits, capables de réaliser un calcul artificiel en 200 secondes, contre plusieurs millénaires pour un supercalculateur classique. Ce jalon, bien que spectaculaire, portait sur un problème à usage essentiellement académique. Aujourd’hui, Google franchit une nouvelle étape en revendiquant un « avantage quantique vérifiable » avec Willow, son processeur quantique de dernière génération, et l’algorithme Quantum Echoes. Cette fois, la promesse concerne une application concrète : la simulation de la structure d’une molécule via la résolution d’Otoc (Out-of-Time-Order Correlators) mesurables par résonance magnétique nucléaire.

Quantum Echoes : sonder la structure moléculaire

Quantum Echoes repose sur l’évaluation de correlateurs quantiques dits « hors ordre temporel », qui captent la manière dont l’information se “rétrempe” dans un système quantique. En pratique, l’algorithme place Willow dans un état préparé, exécute une séquence d’opérations sur les qubits, puis mesure l’« écho » résultant. Cette quantité peut être comparée, d’une part, à une simulation sur un second ordinateur quantique de puissance équivalente, et d’autre part, à des données expérimentales obtenues par spectrométrie par résonance magnétique nucléaire (RMN) sur la molécule réelle.

Un bond de performance de 13 000× ?

Selon Google, l’exécution du même calcul sur le superordinateur Frontier (un mastodonte classique de Oak Ridge) aurait pris environ 13 000 fois plus de temps que sur Willow, pour un problème simulé à 65 qubits. Il faut toutefois distinguer deux volets :

- 65 qubits simulés : la performance record proclamée puise sa comparaison dans un calcul théorique, extrapolé par une modélisation de Willow à grande échelle.

- 15 qubits expérimentaux : la démonstration pratique, réalisée sur un prototype de 15 qubits, a été validée par RMN, mais sans reproduire la même accélération 13 000×, faute de superordinateur classique capable d’un tel comparatif à cette échelle.

Cette distinction souligne la différence entre un exploit mathématique abstrait et une application expérimentale réellement mesurable.

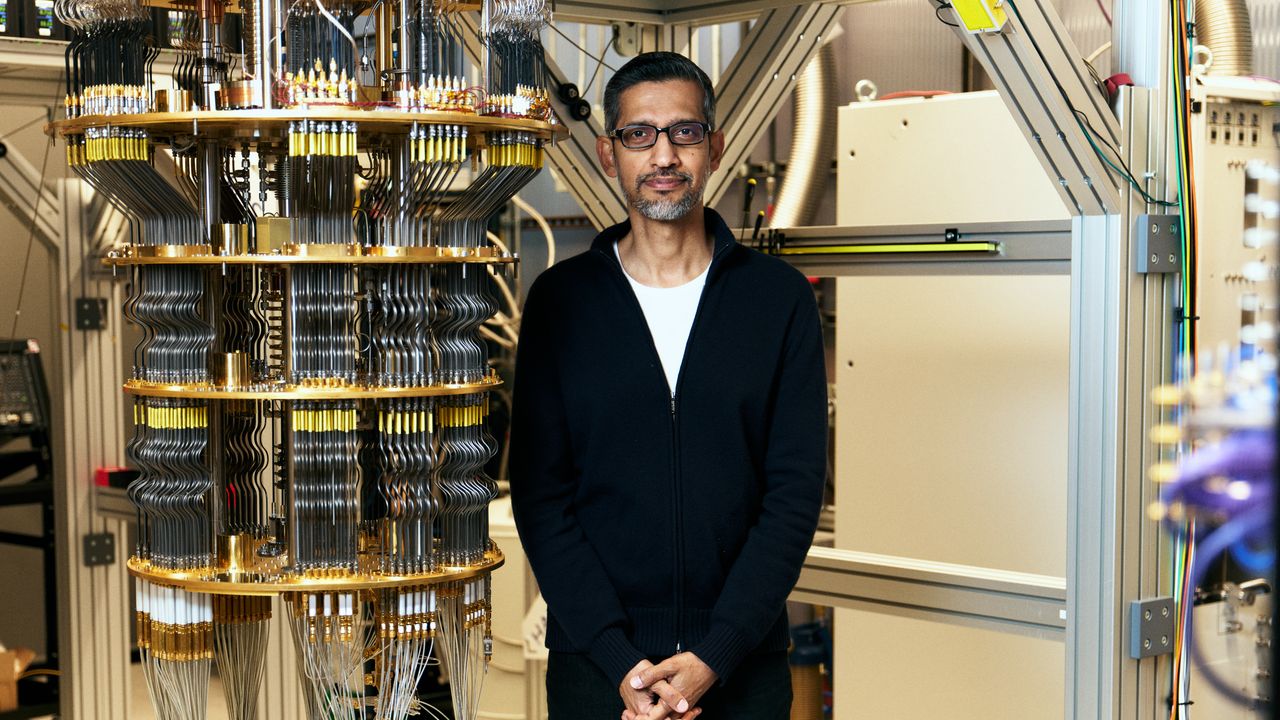

Le rôle central de Willow

Willow, le nouveau processeur quantique de Google Quantum AI, intègre plusieurs avancées technologiques :

- une architecture à base de qubits supraconducteurs optimisés pour réduire le « bruit » et augmenter la cohérence ;

- un circuit de mesure et de contrôle à basse température, assurant une meilleure fidélité des opérations quantiques ;

- une caméra cryogénique et un calibrage automatique pour stabiliser les flux de photons et garantir la répétabilité des expériences.

Ces innovations permettent d’envisager des algorithmes plus longs et plus complexes, tout en conservant un taux d’erreur compatible avec les besoins de simulation moléculaire.

Vérification indépendante et scepticisme

Google insiste sur le caractère « vérifiable » de son avantage :

- la comparaison théorique avec un second ordinateur quantique équivalent, avec lequel effectuer la même mesure d’Otoc ;

- la confrontation aux résultats obtenus par RMN sur la même molécule, offrant une validation expérimentale « physique ».

Cependant, plusieurs points restent à clarifier :

- la réelle vitesse de calcul sur 15 qubits comparée à Frontier ou à d’autres supercalculateurs, pour la même tâche ;

- la robustesse de l’extrapolation de 15 à 65 qubits, basée sur un modèle théorique qui peut diverger de la réalité matérielle ;

- le record de 13 000× n’ayant pas été confirmé par une équipe externe, faute d’accès à un processeur quantique concurrent de même puissance.

Plusieurs chercheurs soulignent la nécessité d’une validation croisée par un autre laboratoire ou par l’industrie, afin d’écarter tout biais de comparaison et d’assurer la solidité du « vantage quantique » annoncé.

Les défis de l’échelle et de la tolérance aux erreurs

Au-delà de la démonstration actuelle, la route vers une simulation utile de biomolécules ou de matériaux complexes exige :

- une montée en qubit : de quelques dizaines à plusieurs milliers ou centaines de milliers de qubits câblés ;

- une réduction drastique du taux d’erreur individuel, via des protocoles d’erreur quantique (QEC) et des qubits plus résistants au décohérence ;

- une infrastructure cryogénique et de contrôle évolutive, capable de gérer les contraintes thermiques et électriques sur un vaste ensemble de qubits.

Les qubits actuels, y compris ceux de Willow, restent vulnérables à la décohérence et aux perturbations extérieures, limitant la durée des algorithmes et la taille des simulations.

Quel avenir pour la simulation quantique ?

L’annonce de Google confirme que les ordinateurs quantiques progressent à pas de géant, passant du simple benchmark abstrait à une simulation physiquement uploadable. Les prochaines étapes incluront :

- la mise au point de QEC plus efficaces pour étendre la taille des calculs sans explosion du taux d’erreur ;

- la standardisation des protocoles de comparaison, fédérant plusieurs acteurs (universités, industries, gouvernements) autour d’un référentiel commun ;

- le développement de cas d’usage industriels concrets : découverte de médicaments, optimisation de catalyseurs chimiques ou conception de nouveaux matériaux.

La route est encore semée d’embûches—scalabilité, coût, tolérance aux erreurs—mais l’atteinte d’un avantage quantique vérifiable place la communauté au seuil d’une phase d’expérimentation applicative majeure, où les promesses de la « révolution quantique » pourraient enfin trouver un terreau fertile.